보통 pyspark는 zeppelin이나 ipython 환경에서 많이 사용하지만

로컬에서 스파크를 사용해야 할 때는 Pycharm에서 개발해야할 때에도 있다.

최근에 연구실에서 파이썬 기반의 다소 규모가 있는 데이터 분석 시스템 개발 프로젝트를 진행하게 되었는데

나는 이 중 데이터 수집과 분석쪽 기능 개발을 맡았다.

대학원 연구실이 시간을 넉넉하게 주는 편은 아니라 엄청나게 고급진 소프트웨어공학적 이론들을 적용하긴 어렵고,

팀원들과 같이 합의한 내용 중 하나는 pycharm 개발환경을 공통적으로 사용하자는 것이었다.

그래서 데이터 분석에서 spark를 사용하는 나는 pycharm에서 pyspark를 사용하게 되었는데 (기존에도 물론 사용하고 있었지만)

이를 처음 시작할 때 연동하는 방법에 관한 포스팅이 의외로 없어서 작성하게 되었다.

0. 환경

OS : Ubuntu 16.04

SW

- PyCharm Professional 2018.3

- Spark 2.2.2

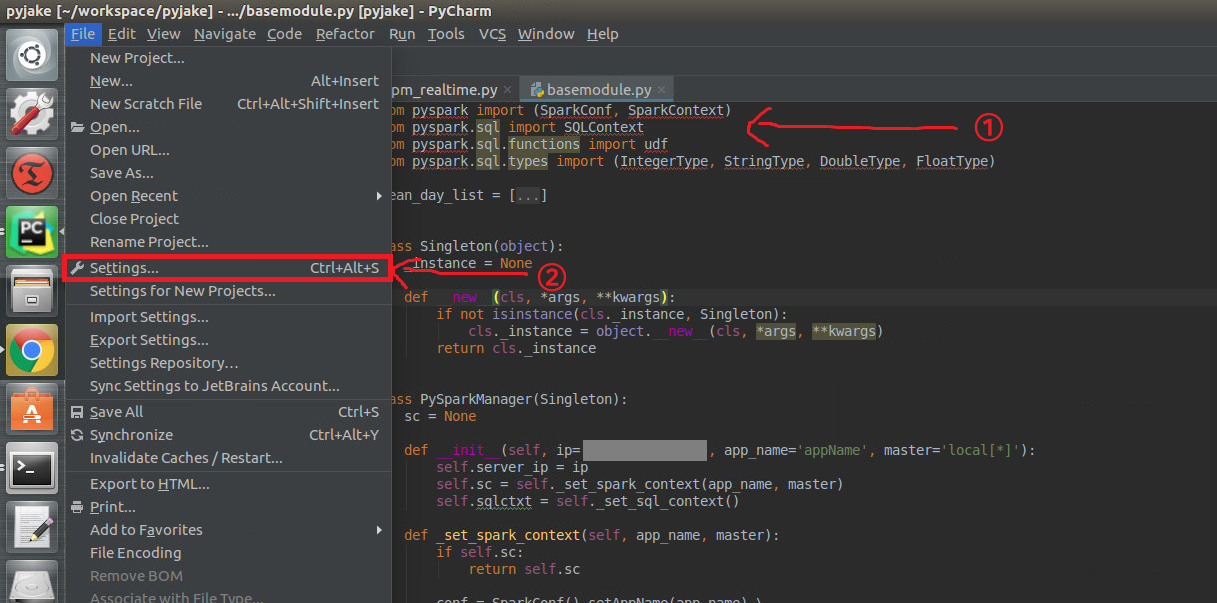

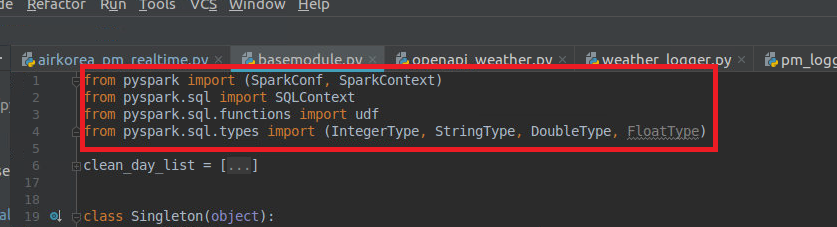

1. import 해보기

①: pyspark를 import하고 코드를 작성해보았다. 인식이 되지 않는 상황.

②: File > Settings에 들어간다.

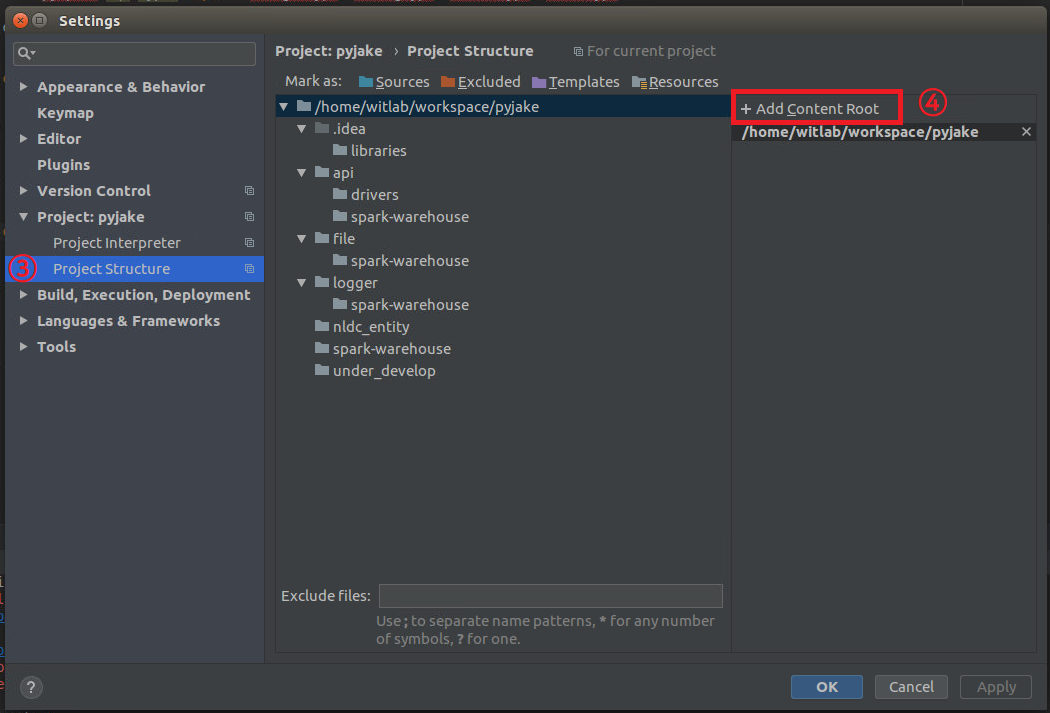

2. Content Root에 PySpark 참조 경로 추가하기

③: Project Structure에 들어간다.

④: Add Content Root를 클릭한다.

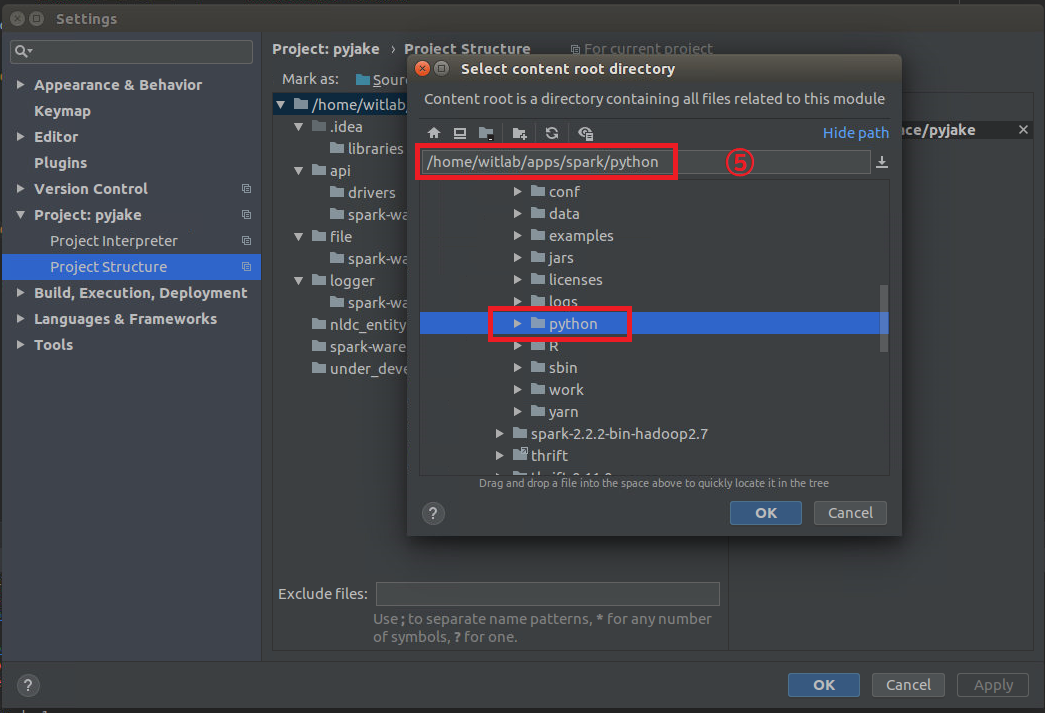

⑤: 경로 추가 - "(spark 홈디렉토리)/python"

⑥: 경로 추가 - "(spark 홈디렉토리)/python/lib/py4j-x.x.x-src.zip"

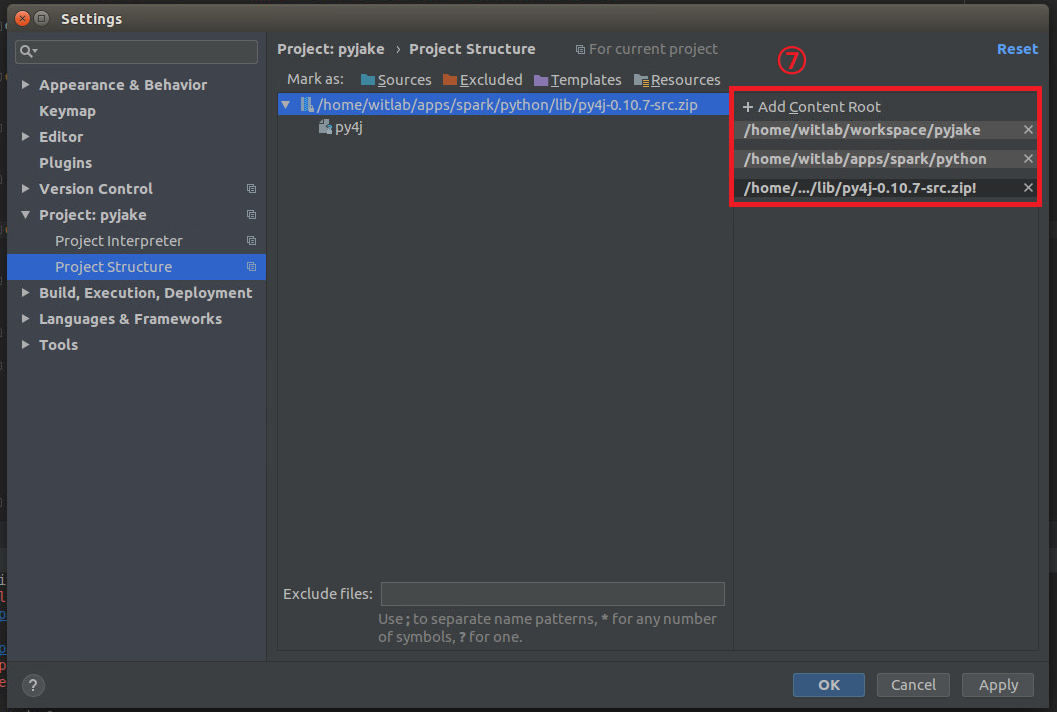

⑦: 확인한다. 위 화면같이 되어있으면 잘 된것.

잠시 기다려보니 잘 인식이 된다!

이제 코드를 실행해보자.

이미지에 쓰인 프로그램은 에어코리아 대기질 API로부터 특정 지역의 대기질 정보를 가져오고 HDFS에 parquet 형식으로 logging하는 파이썬 프로그램이다. spark dataframe을 parquet로 저장할 때 option에 append를 주어 지속적으로 쌓이게 했다. 다음에 이 코드에 대한 포스팅을 통해 소개할 기회가 있으면 좋겠다.

해당 박스 부분은 SparkContext를 불러오는 과정이다. 정상 작동한다.

'Cloud, Bigdata, AI > Big Data Analysis' 카테고리의 다른 글

| [HBase] HBase의 HMaster가 작동 안될 때 (0) | 2018.10.16 |

|---|---|

| [Bigdata] Hadoop, Spark, Zeppelin 연동 시스템 구축 (15) | 2018.10.15 |

| [Hadoop] 하둡 예제 실행 삽질기 (1) | 2017.09.28 |

| [Hadoop] 하둡 설치 삽질기 (1) | 2017.09.21 |